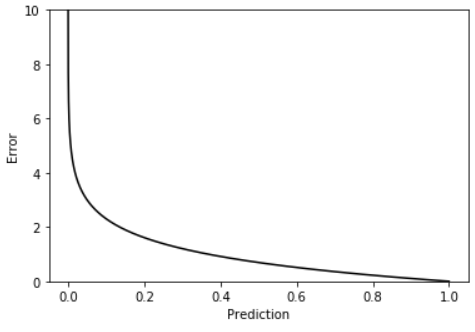

DNN에서 Loss Function을 사용할 때 아래의 2가지 가정에 적합해야 한다. 1) Train data에서의 Loss 총합은 개별 데이터 Loss의 합과 같아야 한다. $$L(\theta_{k}, D) = \sum_{i}L(\theta_{k} ,D_{i})$$ 2) DNN 출력 값으로 Loss를 계산한다. (중간 단계에서의 값으로는 계산하지 않음.) $$\bigtriangledown L(\theta_{k},D) = \sum_{i}\bigtriangledown L(\theta_{k}, D_{i})$$ Mean Squared Error(MSE)와 Cross Entropy Error(CEE)를 Loss Function으로 많이 사용하는 이유는 위의 두 조건을 만족하는 대표적 함수이기 때문이다. 이번 글..