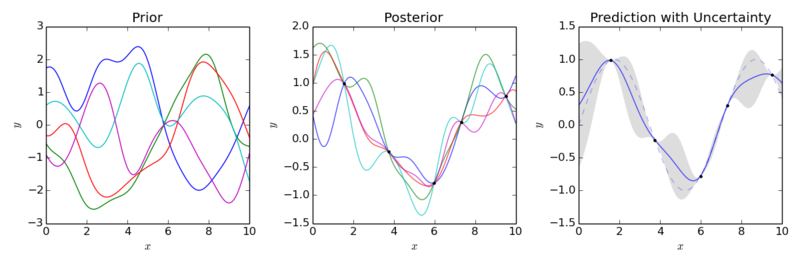

"Simple and Scalable Predictive Uncertainty Estimation Using Deep Ensembles" (ICML 2017) - DeepMind https://www.edwith.org/bayesiandeeplearning/joinLectures/14426 기존의 연구와 한계, 해결책 딥러닝이 발전하며 많은 발전을 이루었지만 아직 부족한 것들이 많이 있다. Uncertainty를 구하는 일이 그중 하나다. 특히 의료, 금융, 자율주행 등의 task에서 overconfident 한 예측은 치명적인 결과를 이끌 수 있기 때문에 불확실성이 더욱 중요한 키워드가 되었다. 이 논문이 나오기 전에 uncertainty를 구하는 방법들은 대부분 베이지안과 관련이 되어 있었다. 베이지..