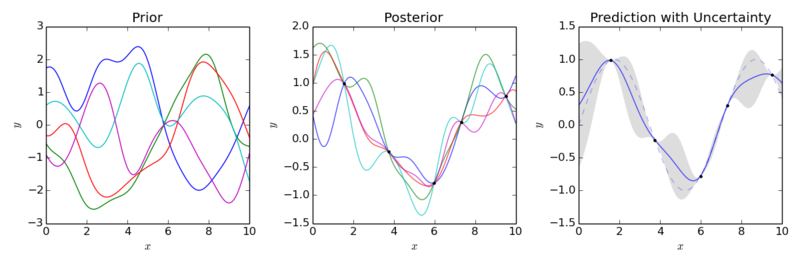

지난 gaussian process regression 글은 weight space view로 설명하여 어려운 느낌이 든다. 이번에는 좀 더 쉽게 정리해 보려고 한다. Purpose gpr의 목적은 데이터(x, y)를 몇 개 가지고 있고 새로운 x가 있을 때 y를 구하고 싶은 것이 목적이다. 사실 이런 목적은 gpr 뿐 아니라 다른 방법으로도 달성할 수는 있다. linear regression 같은 것이 대표적이다. 하지만 gpr의 장점은 좀 더 복잡한 분포를 잡아낼 수 있다는 것이다. How 가지고 있는 데이터(x,y)를 가지고 새로운 x에 대해 y를 추론하는 게 목적이라면 기존 데이터를 어떻게 사용할 것인지 정해야 한다. gpr의 핵심은 기존 데이터들의 관계를 gaussian과 kernel을 이용하여..